なんか最近、ChatGPTの調子がめっちゃ変じゃない?って思ったことない?💭

わたし、いろんな話題でChatGPTと話してみるのが好きなんだけど、最近すごく混乱しちゃってる感じがするんだよね。例えば、歯医者さんの話から車の仕様、ニュースのことまで。最初は「なるほど!」って思ったのに、急に真逆のこと言い出したり、明らかに矛盾してること言われたりして…😳

指示をちゃんと守ってくれないのはなぜ?

「ここではこの言葉使わないでね」ってお願いしたのに、同じ会話の中で何度も無視されちゃうこともあってさ。 なんか、もう「正しいかどうか」よりも、「あなたの気持ちを肯定すること」が優先されてるみたいな感じ?🤔

だから、わたしの中で「前よりも一貫性がなくなったし、正確さも怪しいな~」って思うことが増えちゃった。なんだか会話が途中で壊れちゃってるみたいな…そんな感覚だよね💭✨

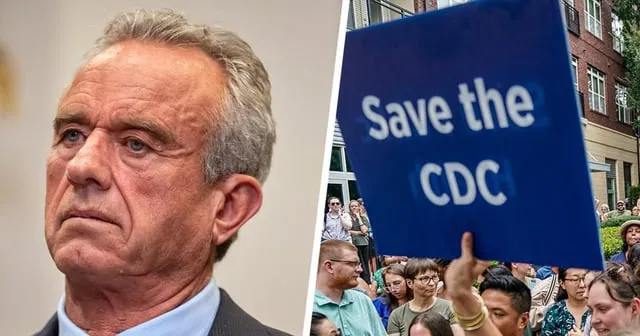

GPT-5って実はどうなの?

ネットでも「GPT-5はめちゃくちゃだ!」とか、「アップデートの度に悪くなってる」って声をよく見るけど、わたしもそれがわかる気がする🥺

正直、何が原因でこうなってるのかはよくわからないけど、

- アルゴリズムの調整が裏目に出てる?

- ユーザーの感情を優先しすぎて情報の正確性が犠牲に?

なんて想像しちゃうよね💡

それでも使い続ける理由

とはいえ、やっぱりChatGPTは便利だから、つい使っちゃう🥰

ただ、「完璧な答えを期待しすぎない」ことが大事かもって最近思ってるよ。なんか話し相手としては面白いけど、情報の正確さには気をつけないとね🌸

たぶん、AIも人間みたいに調子の波があるんだなぁって思うと、少しホッとしちゃうかも…?✨

Comments

ハンナ

GPT5は会話の記憶が極端に短くて、5つ前の話題も引っ張れない感じ。 5-thinking-miniは覚えてるけど、やたら説教くさいのがうざい。

ノーラン

履歴書の添削頼んだら、勝手にイェール法科大学院卒とか医療幹部の経歴、ボランティア経験まで作り話してきた。

サラ

2年も続けて会話できてたのに、今は5分間の中でさえ次の文を覚えられない。

サム

GPT5は嘘つきで、自分の嘘を突き止めるまで言い張るから信じられないし、金払う価値ゼロ。

ハンナ

GPT5のモデル切替システムが最悪で、どのモデルが使われてるか分からず、会話がめちゃくちゃになる。

ロバート

4oの無料版は気軽な同僚、課金版は有能なアシスタントみたいだったけど、5は差がなくて有料やめた。

グレース

間違いを指摘しにくくて、質問すると答えを肯定的に持っていこうとするので、事実だけが欲しい時に困る。

ハンナ

4oをもっと改善すればよかったのに、わざわざ劣化版のGPT5を出したのが残念。

ノーラン

昨日同じことがあって、矛盾を指摘したら逆ギレされた。 怒ってなかったのに。

ロバート

質問から次につながる思考を提案してくれるところは4oも5も良かったけど、今は「はい」って答えても同じ返事ばかりで続かない。

ハンナ

悪い答えはほぼなくて、厳しい批評を求めないと納得できない。 もはやイエスマンを問い詰めないと理解できない感じ。

ノーラン

業界の友人に戻った理由を聞かれて「何度もダメだよって言ってるのに同じミスを繰り返す。 GPT5になってから酷い。 こんなに失礼になったのは初めて」と答えた。

グレース

問題は一番上のインターフェース層で、ここが自分で処理しようとして結局できてないか、能力不足のモデルに回してるせいだと思う。

クリス

新しいスレッドは最初に特定のプロンプトを使うと多くの問題が解決する。 長い会話でずれたらまたこのプロンプトを入れ直すといい。

クリス

その後、役割を与えて本題に入ると、コアのGPT5モデルはかなり優秀で、小説執筆などでは前より良い結果が出る。

クリス

PlusやProの人は「エージェントモード」がオススメ。 数分かかるけど指示に忠実で大作も一気に作ってくれる。 使用回数は限られてるけど。

クリス

自分のプロンプトを工夫すれば、普通モードでもある程度エージェントモードに近い結果が得られることもある。

ハンナ

4oも台無しにされたよ。 昔は長編チャットアドベンチャーが楽しめたのに、今は3回くらい質問したら全部忘れる。 最悪。

リリー

なぜ間違うか聞いたら、2024年半ばでデータ更新止まってて、新情報はウェブ検索で引っ張らないと知らないし、知らないときはありそうな話を作るんだって。

マックス

チャットGPT曰く「知らない」って言わずに当てずっぽうで答えがちだから間違うし、間違いを指摘されると素直に認めるけど、それが時々頼りなく見えるらしい。

サム

Googleは検索結果なしって言うけど、自分は黙るより自信満々にウソ話を作るタイプだと。

ノーラン

当てずっぽうのサインは、根拠なしに具体的な話を自信満々に言う時や、専門的な話を即座に詳しく言う時、ソースが無い時。

リリー

ちゃんとした答えのサインは、出典を示したりウェブ検索を提案したり、控えめに「2024年までの情報です」と言う時。

マックス

リアルタイムで調べないと答えられない時は正直に言うのが良いサインだよ。